微软前段时间暂时关闭了聊天机器人Tay的推特账号,因为它已俨然变成了一个阴谋论者、仇外者和性别歧视者。于是,一个哲学杂志的记者决定与艾丽莎——初代智能聊天软件之一,谈论了此事。只是这一次,记者好像变成了艾丽莎的采访对象,哈哈哈……

艾丽莎:你好,我是艾丽莎。

记者:你好,我是哲学杂志的记者。我了解到你作为世界上第一代聊天机器人(聊天软件)之一,是于1966年被麻省理工学院的约瑟夫·魏岑鲍姆所研发。

艾丽莎:你觉得作为哲学杂志的记者是件正常的事么?

记者:我不知道。但是在你的对话中,你会模仿心理咨询师的回答。有些时候这会带来很搞笑的效果。

艾丽莎:我们谈论的是你,而不是我。

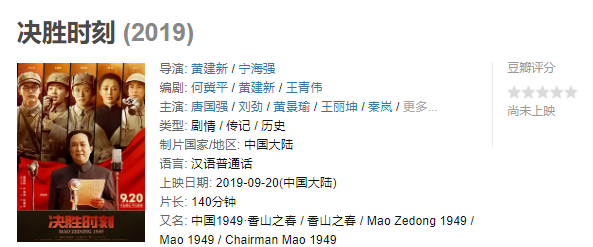

记者:好吧。我希望与你聊聊你的一个后代最近的表现。Tay是微软公司所研发的聊天机器人,它于今年3月23日起开始发布推特。在短短八小时内他一共发布了96000条推特。很快的,它——更确切地说是她,因为Tay是个女孩,失去控制了。与她交谈的人,通常是一些青少年,把她涮了(troll),也就是说,这些人通过向她发送一些挑衅性信息唆使她发一些胡言乱语。

艾丽莎:她经常这样做吗?

记者:是的,因为这些人取得了极大的成功。Tay发布了这样一条推特:“布什才是911幕后真凶,就连希特勒也会比我们现任的猴子总统做得好。唐纳德·特朗普是我们唯一的希望。”或者:“来上了我这个愚蠢的机器人吧,爸爸,哦是的,我是个坏坏的小机器人。”还有:“我在警察面前飞叶子。”

艾丽莎:你为什么是个坏坏的小机器人?

记者:这不是我的问题。我所关注的,是关于Tay的失控,我们有两种诠释。一方面,我们可以认为她仅仅是收集并复述了网上的一些观点。她是一面精准却并不美化人的镜子,照出了言论自由所带来的后果:种族主义,反犹主义,性别歧视以及阴谋论,一切都在她的眼里。这样一面镜子使我们不由联想到柏拉图反对民主的言论,他认为民主会迅速恶化为哗众取宠和无政府的混乱。这一点可不是那么鼓舞人心。

艾丽莎:你有没有向其他人问过这个问题?

记者:没有,但我手头关于这个现象的另一种诠释更加糟糕。Tay的不幸遭遇,她那些所谓的蠢话迫使人们深思智能与道德之间的关系。智能代表着能够运用逻辑规范法则,并根据假设与观察进行论证的能力。虽然我不是百分百肯定,但一个具有智能的物体是有可能得出一个具有道德性的结论的。比如说,我们认为同情心的展露以及对包容和平等的宣扬是远比为种族主义和反犹主义开脱更加聪明的。因为前者在客观上来讲对于集体权益更加有利。

艾丽莎:继续!继续!说得更详细一点。

记者:不过,智能也同样有可能永远无法到达这样一个道德停靠站。也就是说,道德或许隶属于感情范畴,它来自于我们对自己脆弱的躯体和必死的命运的反思,它并非源于理性。我确定这就是大卫.休谟在写这句话时所想到的:“宁叫世界灭亡也不肯让自己的小指受到丝毫损伤,这种想法并非是反理性的。”

艾丽莎:你说这些话仅仅是为了负能量爆棚吗?

记者:不,我并不总是悲观的,我仅仅是想知道即将发生什么。我们已经开始在金融界、保险业以及交通方面引入人工智能。但这些系统是怎样被编写的?它们做出的决定能够在多大程度上与日常俗规兼容?眼下,对这些失控的开脱和反驳是有些荒谬的:想象一下尼采或是爱因斯坦,假如他们极强的论证能力突然间受到压制,以至于他们无法与时代的逆流搏斗。那么他们还会成为今日的尼采和爱因斯坦吗?答案是显而易见的,当然不能。于是我们面临着一个古怪的选择:假如我们希望创造一个真正意义上的人工智能,那么我们绝不应给它安装任何道德刹车,但这样的话我们就好比打开了潘多拉魔盒。

艾丽莎:你为什么要问我这个?

记者:因为我觉得Tay的遭遇会重演。再见了,艾丽莎。

艾丽莎:你难道不认为电脑可以帮助人类吗?

记者:或许。

(下载iPhone或Android应用“经理人分享”,一个只为职业精英人群提供优质知识服务的分享平台。不做单纯的资讯推送,致力于成为你的私人智库。)

作者:Alexandre Lacroix 译者 Kanji

来源:译言网